¿Qué es la «prueba de Turing» y qué robots la han aprobado hasta ahora?

Ciencia

Por: Yael Zárate Quezada - 04/19/2025

Por: Yael Zárate Quezada - 04/19/2025

Una de las interrogantes que ha habitado la mente de científicos, escritores y tecnólogos desde hace décadas es si las máquinas pueden pensar como los seres humanos. ¿Las miles de millones de conexiones diarias que generan nuestras neuronas podrían compararse con los millones de código que debe procesar una computadora para asemejarse lo más posible al lenguaje humano?

La inteligencia artificial ha avanzado tanto en los últimos años, que el futuro que se creía distante a principios del siglo XX ha generado progreso tras progreso en muy poco tiempo y ahora, además de ser parte de nuestra vida cotidiana, también es capaz de engañar a personas en conversaciones naturales. Recientemente, varios modelos de lenguaje fueron sometidos a una de las pruebas más icónicas para evaluar inteligencia artificial: la prueba de Turing.

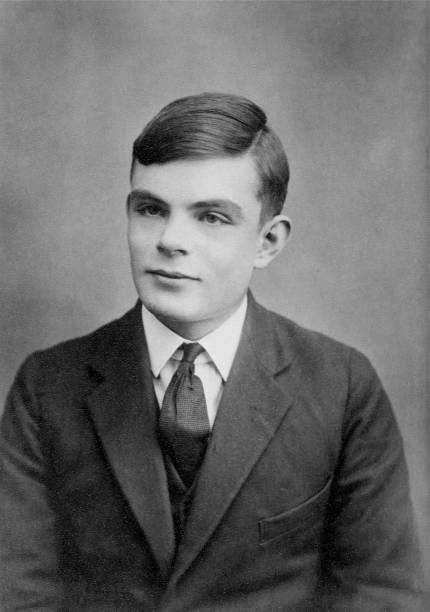

Esta prueba fue ideada en 1950 por Alan Turing, genio nato y uno de los pioneros de la computación moderna. Su objetivo era establecer un criterio claro para saber si una máquina puede considerarse inteligente o no. En lugar de buscar una definición abstracta de inteligencia, Turing propuso una dinámica que constituía en que si una computadora puede hacerse pasar por humana en una conversación escrita, entonces puede decirse que "piensa".

En el experimento, un evaluador humano mantiene una conversación con dos entidades a través de texto: una es una persona, y la otra una máquina. El evaluador no sabe quién es quién. Al final, debe decir cuál cree que es el humano. Si la máquina logra engañar al evaluador en al menos la mitad de las ocasiones, se considera que ha pasado la prueba.

Para responder esta pregunta hay que conocer la hazaña de un equipo de investigadores del Laboratorio de Lenguaje y Cognición de la Universidad de California en San Diego que decidió poner a prueba varios modelos de lenguaje actuales, incluyendo algunos de última generación. Participaron 126 estudiantes universitarios y 158 usuarios de la plataforma Prolific, sin decirle a nadie que formarían parte de un experimento tan significativo.

Los participantes mantuvieron conversaciones en línea de cinco minutos con un humano y con un robot, sin saber quién era quién. Los resultados indicaron que GPT-4.5 fue percibido como humano en el 73% de las ocasiones, lo que indica no sólo que pasó la prueba, sino que lo hizo con una ventaja considerable.

Otro modelo, LLaMa-3.1, también logró superar el test, con el 56% de las veces con la tendencia de que conversaban con un ser humano. El chatbot Eliza, creado en los años 60, también fue incluido en el experimento, aunque su capacidad de engañar fue considerablemente menor.

Con estos descubrimientos al menos una pregunta fundamental se impone: ¿qué significa realmente “pensar”? ¿Qué tan cerca estamos de una IA que no solo imite el lenguaje, sino que entienda la experiencia humana? Y lo más inquietante es ¿cómo sabemos con quién estamos hablando?